A inteligência artificial (IA) está reformulando não apenas produtos e processos, mas os próprios fundamentos das decisões empresariais. O que antes era domínio exclusivo de áreas técnicas passou a ser uma responsabilidade compartilhada com os conselhos de administração, que agora têm o dever de garantir que a IA esteja a serviço da estratégia, da ética e da sustentabilidade organizacional.

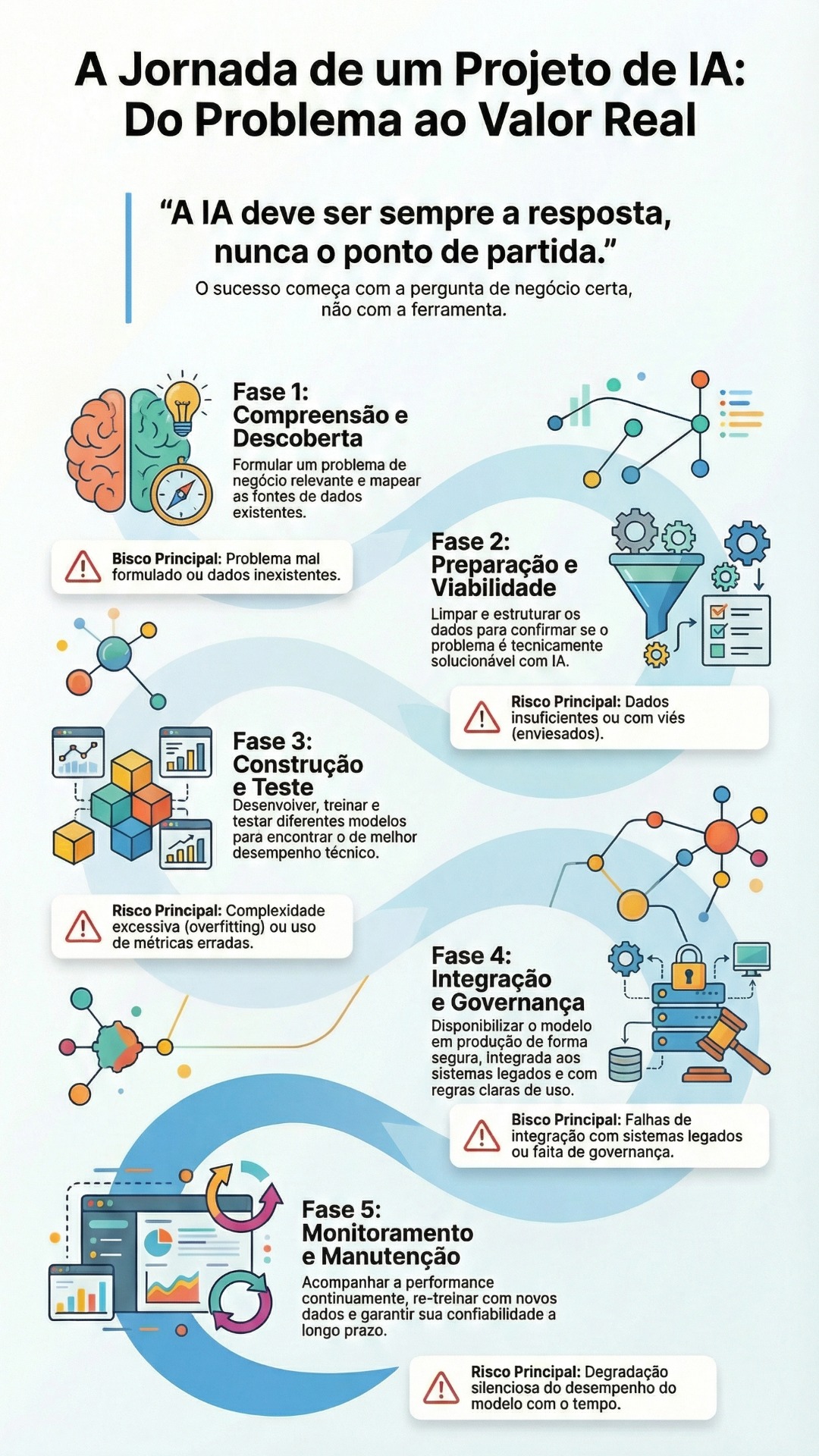

A adoção de IA precisa deixar de ser fragmentada e experimental para se tornar planejada e responsável. Isso exige que os conselheiros compreendam dois instrumentos-chave: o roadmap e a governança da IA. O primeiro revela onde a empresa está e para onde pode ir. O segundo define os limites, responsabilidades e mecanismos de controle ético, técnico e jurídico. Ambos são pilares estratégicos — não operacionais — e devem ser tratados como tal no nível do board.

Conselhos bem preparados cobram dos executivos não apenas desempenho, mas também critérios claros de explicabilidade, mitigação de vieses, segurança algorítmica e conformidade com legislações como a LGPD e o futuro EU AI Act. Eles incentivam a criação de comitês de ética, indicam responsáveis por MLOps e exigem relatórios periódicos de risco, além de planos de resposta a incidentes e rollback.

O uso responsável da IA envolve escolhas difíceis. Maximizar performance pode significar sacrificar equidade. Adotar modelos de última geração pode comprometer a explicabilidade. Automatizar por completo uma decisão crítica pode excluir o fator humano. Nessas situações, o conselho não precisa saber programar — mas precisa saber fazer as perguntas certas, cobrar testes de impacto, exigir planos de mitigação e supervisionar os trade-offs assumidos.

Referências internacionais como o NIST AI RMF e o modelo AI-C2C apontam a direção. Empresas como IBM, AstraZeneca e Mastercard já estruturaram suas estratégias com comitês interdisciplinares, frameworks éticos e avaliação contínua de maturidade. Os conselhos dessas empresas não apenas supervisionam — eles direcionam.

O papel do conselho evolui. Não basta mais vigiar riscos. É necessário liderar a jornada da IA com visão de longo prazo, integrando o tema às discussões estratégicas, aos comitês de risco, compliance, inovação e ESG. Isso exige capacitação contínua e atualização sobre o ciclo de vida dos sistemas de IA, vieses algorítmicos, governança de dados e regulamentações emergentes.

Conselheiros preparados transformam complexidade em ação. Promovem confiança digital. E garantem que a inteligência adotada pelas organizações seja, acima de tudo, ética, explicável e alinhada ao propósito.

Guia estratégico para conselhos: 5 ações imediatas

- Solicite um diagnóstico da maturidade em IA da organização.

- Exija a inclusão da IA na pauta dos comitês de risco, inovação e ESG.

- Apoie a criação (ou revisão) da política de governança de IA.

- Indique um conselheiro responsável ou institua um comitê de IA.

- Inicie a capacitação contínua do board com base em boas práticas globais.

Para aprofundar cada uma dessas ações, leia o artigo completo: