1. A Reconfiguração Estratégica: Do Modelo Generalista à Inteligência de Domínio

Em 2026, a posse de um “modelo base” de trilhões de parâmetros tornou-se um ativo secundário. O verdadeiro diferencial competitivo migrou para a orquestração profunda e a integração simbiótica com o ecossistema proprietário. Sob minha perspectiva como estrategista, o “Pivô Estratégico” da Apple ao integrar o Gemini 3 do Google em sua arquitetura de nuvem não é uma derrota técnica, mas um movimento magistral de eficiência financeira e foco em User Experience (UX). Ao tratar o Large Language Model (LLM) de fronteira como uma commodity de alto desempenho, a organização libera capital para dominar as camadas onde a captura de valor é resiliente: a interface, a identidade e o silício.

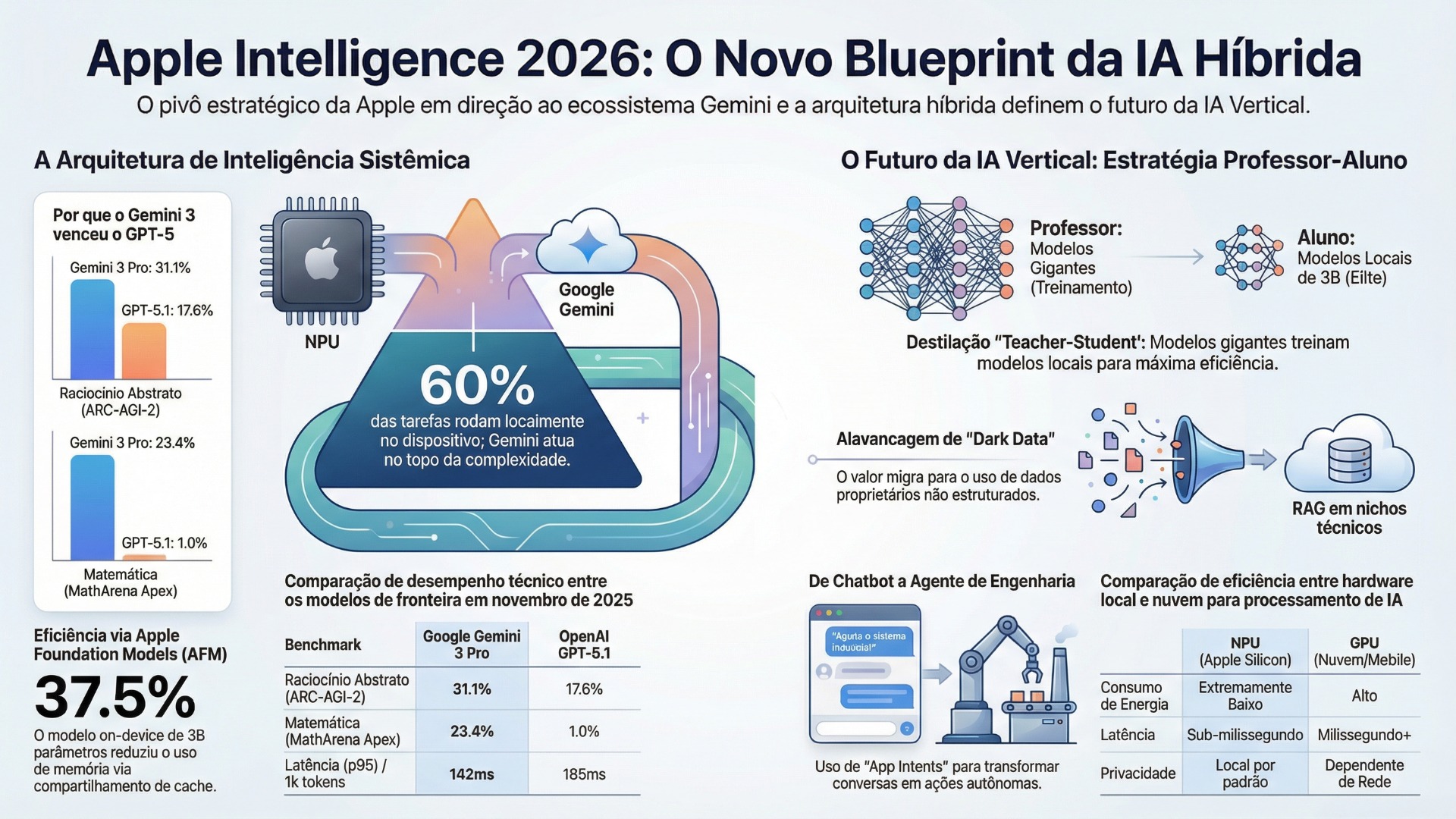

A transição foi impulsionada pela superioridade do Gemini 3 (lançado em novembro de 2025) em relação ao GPT-5.1. Enquanto a solução da OpenAI foi criticada por uma abordagem “fria” e pela incapacidade de superar a “barreira dos 10%” no aprendizado contínuo — agindo meramente como um “empreiteiro” de tarefas isoladas —, o Gemini demonstrou uma memória institucional superior devido à sua natureza multimodal nativa.

Benchmarks de Fronteira (Contexto Novembro 2025):

| Benchmark | Google Gemini 3 Pro | OpenAI GPT-5.1 | Diferença Percentual |

| ARC-AGI-2 (Raciocínio Abstrato) | 31.1% | 17.6% | +76.7% |

| MathArena Apex (Matemática Inédita) | 23.4% | 1.0% | +2240% |

| MMMU-Pro (Raciocínio Multimodal) | 81.0% | 76.0% | +6.6% |

| Latência (p95) por 1k tokens | 142ms | 185ms | -23.2% |

Esta convergência permite que as lideranças abandonem a exaustiva corrida de treinamento geral para focar na orquestração. No entanto, para sustentar tal arquitetura híbrida, a sobrevivência competitiva dita a adoção imediata de métodos eficientes de transferência de conhecimento.

2. Metodologia Professor-Aluno (Teacher-Student): Destilação para Eficiência de Elite

O dilema entre potência bruta e viabilidade econômica é resolvido através da arquitetura Professor-Aluno. Este não é apenas um método de compressão, mas uma estratégia de “Elite Efficiency”, onde modelos “Professores” (como o Gemini de 1,2 trilhão de parâmetros) treinam modelos “Alunos” especializados de 3 a 7 bilhões de parâmetros.

A sofisticação técnica reside na destilação de conhecimento. No caso dos Apple Foundation Models (AFM), a eficiência de memória é alcançada via KV Cache Sharing (Key-Value), onde o modelo é dividido em blocos que reutilizam as projeções anteriores. Este “moat” arquitetural permite que o dispositivo opere com uma agilidade sem precedentes.

Para nichos de missão crítica, como a Engenharia, a divisão de funções é mandatória:

- Modelo Professor (Nuvem): Detém o raciocínio de fronteira, lógica global e interpretação de normas complexas (ex: IEC 62443).

- Modelo Aluno (On-Device/Edge): Executa triagem local, diagnósticos rápidos e resumos técnicos com latência sub-milissegundo.

A utilização de modelos menores e quantizados (2-bit ou 4-bit) é o único caminho para mitigar o OpEx insustentável dos modelos de fronteira. Contudo, esses “Alunos” só geram valor se alimentados por dados que a inteligência generalista desconhece.

3. Vertical AI: Alavancagem de “Dark Data” via RAG

A nova fronteira da vantagem competitiva reside no “Dark Data” — ativos proprietários não estruturados que modelos horizontais jamais acessaram. Enquanto as IAs generalistas alucinam em workflows técnicos, a IA Vertical utiliza o RAG (Retrieval-Augmented Generation) para conectar o LLM a bancos de dados de vetores institucionais.

O caso da nMentors Engenharia é o blueprint ideal: seu fosso defensivo não é o modelo em si, mas seus 17 anos de histórico em usinas solares flutuantes, integração SCADA e Digital Twins. Ao injetar esse contexto via RAG, o sistema deixa de “adivinhar” para “consultar” fatos concretos.

A IA Vertical mitiga riscos em ambientes de missão crítica ao garantir que a geração de respostas esteja ancorada na telemetria IIoT e em manuais técnicos proprietários. O controle sobre o contexto histórico e os dados de telemetria cria um “moat” que as Big Techs generalistas não conseguem cruzar, transformando a IA em um especialista de domínio infalível.

4. A Evolução do Agente: App Intents e Orquestração de Workflows

A era dos chatbots passivos acabou. Estamos na transição para agentes sistêmicos que superam a “amnésia institucional” através de gráficos de contexto persistentes. O framework de App Intents permite que a IA não apenas “fale”, mas “leia” a tela e execute ações coordenadas entre múltiplos aplicativos.

Utilizando o exemplo da nMentors, o fluxo evolui de uma consulta para uma ação autônoma:

- Diagnóstico: Um sensor detecta anomalia térmica via telemetria.

- Raciocínio: O agente consulta o Digital Twin e o histórico de manutenção de 17 anos via RAG.

- Execução: Através de App Intents, o agente ajusta o sistema supervisório e gera automaticamente uma ordem de serviço no ERP.

Esta capacidade de planejamento multi-etapa transforma a IA de um “empreiteiro temporário” em um agente sistêmico capaz de aprendizado contínuo, essencial para a autonomia operacional.

5. Otimização de Infraestrutura: Silício, NPUs e Nuvem Híbrida

O custo da IA é, em última instância, um custo de energia. A estratégia de software deve ser escrava do hardware para garantir viabilidade. O co-design entre o silício (NPUs) e a stack de software (framework Metal Performance Shaders – MPS) permite que modelos acessem a memória unificada com larguras de banda de até 546 GB/s (como no M4 Max), eliminando gargalos de VRAM.

A eficiência energética é o KPI definitivo:

Para gerenciar a escala, a arquitetura deve utilizar o Parallel Track Mixture-of-Experts (PT-MoE), que reduz o overhead de sincronização em 87.5% em relação ao paralelismo de tensores tradicional.

Especificações Técnicas da Stack Híbrida

| Modelo | Localização | Escala de Parâmetros | Especialidade |

| On-Device (AFM) | NPU Local | ~3 Bilhões | Ações em Apps e Triagem Local |

| Server (AFM MoE) | Private Cloud | ~150 Bilhões (PT-MoE) | Raciocínio Institucional |

| Gemini Custom (PCC) | Private Cloud | ~1,2 Trilhão | Conhecimento Global e Fronteira |

6. Governança e Segurança: O Modelo Private Cloud Compute (PCC)

A soberania de dados em 2026 exige o modelo Private Cloud Compute (PCC). Diferente da nuvem pública, o PCC é uma arquitetura sem estado (stateless) onde os dados são processados apenas em memória e descartados. O uso de atestação criptográfica garante que o dispositivo do usuário só libere informações após verificar que o servidor executa um software íntegro e auditado.

Os cinco pilares do PCC são inegociáveis para a confiança corporativa:

- Computação Sem Estado: Descarte imediato pós-processamento.

- Garantias Imponíveis: Ausência de interfaces SSH ou acessos privilegiados para administradores.

- Não-Targetability: Impossibilidade de atacar usuários específicos de forma isolada.

- Transparência Verificável: Auditoria pública via Virtual Research Environment (VRE).

- Cadeia de Suprimentos Integrada: Controle total do silício Apple ao sistema operacional.

7. Conclusão: O Imperativo do “Make-or-Buy” e o Futuro da IA Invisível

O modelo Apple-Gemini ensina que o futuro pertence àqueles que modularizam a inteligência bruta e investem no que é proprietário.

Guia de Decisão Estratégica:

- Buy (Comprar): Adquira a cognição generalista de provedores como o Google. É uma necessidade financeira para acessar o topo da pirâmide de conhecimento global sem o custo de treinamento.

- Make (Fazer): Invista agressivamente no design de workflows, na captura de “Dark Data” (Digital Twins/SCADA) e na arquitetura Professor-Aluno. Esta é a única forma de evitar a amnésia institucional e criar um fosso defensivo real.

A IA deixará de ser uma ferramenta de conversação para se tornar um “sistema operacional invisível”. O valor organizacional migrará da conversa para a execução autônoma, onde a inteligência atua silenciosamente no “edge”, protegida por silos de dados proprietários e garantias criptográficas invioláveis.