Introdução

Vivemos uma inflexão histórica. A inteligência artificial (IA), antes restrita aos laboratórios de pesquisa e aos roteiros de ficção científica, tornou-se uma tecnologia ubíqua e estratégica para empresas em praticamente todos os setores. Mais do que uma tendência tecnológica, a IA representa uma mudança profunda nos modelos de negócios, nas formas de trabalho e, sobretudo, nas estruturas de decisão. Nesse cenário, os conselhos de administração têm um novo desafio — e uma oportunidade singular: orientar a adoção de IA de forma estratégica, ética e responsável.

O papel estratégico dos conselhos na era da IA

Historicamente, os conselhos de administração concentram-se em questões como crescimento sustentável, gestão de riscos, conformidade regulatória e sucessão de lideranças. Com a digitalização crescente, muitos conselhos passaram a incorporar a governança de TI em suas pautas. A inteligência artificial, no entanto, exige uma abordagem mais ampla e profunda. Isso porque seus impactos transcendem a tecnologia: afetam valores organizacionais, cadeias de decisão automatizadas, relações com consumidores e trabalhadores, e até a reputação institucional.

A adoção de IA pode ampliar a produtividade, melhorar a experiência do cliente e abrir novas frentes de inovação. Mas também carrega riscos: vieses algorítmicos, decisões opacas, riscos regulatórios e impactos sociais não previstos. É nesse ponto que o conselho se torna essencial. Não se trata de dominar o código-fonte, mas de compreender o suficiente para fazer as perguntas certas, exigir transparência e garantir que o uso de IA esteja alinhado com os princípios e objetivos da organização.

Por que conselheiros precisam entender roadmap e governança

Para que a IA produza valor de forma sustentável, é necessário planejamento estratégico e mecanismos de governança robustos. Isso implica construir um roadmap de IA — um plano estruturado que oriente desde os primeiros experimentos até a adoção em larga escala — e definir um modelo de governança que assegure a conformidade, a equidade, a transparência e o controle contínuo.

O roadmap permite que conselheiros visualizem onde a empresa está e para onde pretende ir em termos de maturidade em IA. Já a governança define os limites, as responsabilidades e os mecanismos de auditoria e monitoramento — algo especialmente necessário quando decisões começam a ser automatizadas.

Na ausência de um roadmap claro, os investimentos tendem a se dispersar em projetos isolados e desconectados da estratégia do negócio. E sem governança, os riscos se amplificam silenciosamente até que algum evento crítico revele falhas sistêmicas. Ao dominar esses dois instrumentos — roadmap e governança — os conselheiros ganham capacidade real de direcionar, aprovar ou vetar iniciativas com base em critérios técnicos e éticos sólidos.

Objetivos do artigo

Este artigo foi escrito com um propósito claro: oferecer aos conselheiros de administração uma base confiável e prática para avaliar a maturidade em IA de suas organizações, entender as etapas de um roadmap eficiente e cobrar dos executivos uma governança alinhada às melhores práticas internacionais.

Ao longo do texto, serão apresentados:

- As dimensões críticas de um roadmap de IA;

- Os princípios fundamentais de uma boa governança;

- Tabelas de autoavaliação para conselhos;

- Exemplos de estruturas e mecanismos que podem (ou devem) ser exigidos dos executivos;

- Perguntas-chave que ajudam a diagnosticar riscos e oportunidades no uso da IA.

Mais do que um guia técnico, este é um convite para que conselhos assumam seu papel na era da inteligência artificial: o de garantir que as decisões algorítmicas — por mais complexas ou autônomas que sejam — estejam sempre a serviço da estratégia e dos valores da organização.

Tabela-resumo: O papel do conselho na era da IA

| Dimensão | Papel do Conselho | O que deve ser exigido dos executivos |

| Estratégia | Integrar a IA à visão de longo prazo | Roadmap de IA alinhado ao plano estratégico |

| Riscos e Ética | Avaliar impactos e riscos éticos | Políticas de uso responsável e mitigação de vieses |

| Governança e Conformidade | Assegurar accountability e compliance | Comitês de IA, auditorias, registro de decisões algorítmicas |

| Inovação | Estimular uso criativo com responsabilidade | Propostas com plano de impacto, métricas e ROI claros |

| Transparência e Supervisão | Demandar explicabilidade e supervisão contínua | Modelos auditáveis, com logs e documentação acessível |

| Capacitação e Cultura | Preparar a organização para convivência com IA | Programas de alfabetização em IA e cultura de dados |

Panorama: O avanço da IA nas organizações

A inteligência artificial deixou de ser apenas uma promessa para se tornar um vetor ativo de transformação em empresas dos mais diversos setores. Desde algoritmos que otimizam estoques até modelos generativos que personalizam experiências de clientes em tempo real, a IA já está inserida nos fluxos decisórios, operacionais e estratégicos de negócios modernos. Porém, com seu potencial revolucionário, surgem também novas responsabilidades e riscos que não podem ser ignorados — especialmente por conselhos de administração.

IA como vetor de transformação: eficiência, novos modelos e riscos

No centro da transformação digital contemporânea, a IA funciona como um acelerador de eficiência e um catalisador de novos modelos de negócio. No setor financeiro, por exemplo, algoritmos otimizam decisões de crédito em milissegundos. Na indústria, a IA acelera a manutenção preditiva e a automação de processos. No varejo, ela antecipa comportamentos de consumo e ajusta estoques dinamicamente. A promessa da IA está em sua capacidade de lidar com volume, variedade e velocidade de dados em escalas humanas inalcançáveis.

No entanto, esse mesmo poder pode gerar assimetrias de decisão, vieses sistêmicos e perda de controle se não houver uma estrutura de governança sólida. A literatura recente alerta para o risco de uma “governança enviesada” — ou seja, estruturas que adotam princípios éticos apenas no discurso, sem mecanismos práticos de controle e supervisão.

Esse desalinhamento entre princípios e práticas pode ter consequências sérias: desde falhas de reputação e perda de confiança, até sanções legais. O caso emblemático da falha algorítmica em sistemas de recrutamento ou pontuação de crédito demonstra que mesmo modelos bem intencionados podem produzir discriminação, opacidade ou injustiça se não forem supervisionados adequadamente.

Pressão por inovação versus responsabilidade

Executivos e líderes de negócio enfrentam uma tensão crescente: de um lado, a pressão por inovar, automatizar e ganhar vantagem competitiva; de outro, a necessidade de adotar práticas responsáveis, explicáveis e auditáveis. Essa dualidade tem levado à formulação de frameworks e normas que tentam equilibrar inovação e responsabilidade.

O framework AI-C2C (conscious to conscience), por exemplo, propõe um modelo em fases para evoluir da adoção consciente da IA até sua integração ética com estruturas humanas e organizacionais. Ele sugere, entre outros elementos, a criação de comitês de ética em IA, o papel do Chief AI Officer e a definição clara de responsabilidades por tipo de uso.

Em paralelo, cresce o movimento internacional por marcos regulatórios mais robustos. Isso exige que as organizações se antecipem não apenas aos ganhos tecnológicos, mas também aos requisitos éticos e legais que estão por vir.

Marcos regulatórios e frameworks de referência

Duas iniciativas têm se destacado como norteadoras para conselheiros que desejam compreender os padrões emergentes:

- NIST AI Risk Management Framework (AI RMF) – Desenvolvido pelo Instituto Nacional de Padrões e Tecnologia dos Estados Unidos, o AI RMF estabelece diretrizes práticas para identificar, avaliar, mitigar e monitorar riscos associados a sistemas de IA. Ele destaca os pilares de confiança, governança e segurança como centrais para qualquer sistema confiável de IA .

- EU AI Act – Proposto pela Comissão Europeia, o AI Act classifica sistemas de IA por nível de risco (mínimo, limitado, alto e inaceitável) e impõe obrigações legais específicas para cada categoria. Isso significa que conselhos precisam acompanhar o enquadramento regulatório das soluções que suas empresas estão implementando, sob pena de responsabilidade solidária por falhas estruturais.

Esses marcos apontam para um novo padrão global de responsabilidade, em que não basta adotar IA — é preciso demonstrar que ela foi concebida, treinada e utilizada de forma responsável, segura e transparente. Cabe aos conselhos garantir que suas organizações estejam preparadas para esse novo ambiente regulatório e reputacional.

Tabela-resumo: Panorama da IA nas organizações

| Dimensão | Potencial de valor | Riscos associados | Exigências para conselhos |

| Eficiência Operacional | Automatização, redução de custos | Decisões opacas, erro sistêmico | Avaliar uso responsável e auditável |

| Modelos de Negócio | Novos produtos, hiperpersonalização | Dependência tecnológica, lock-in algorítmico | Exigir estratégia de IA clara |

| Decisão Baseada em Dados | Velocidade e precisão na análise | Viés, discriminação, injustiça | Cobrar validação e testes de impacto |

| Conformidade e Regulação | Acesso a mercados regulados | Penalidades legais e reputacionais | Mapear riscos sob AI RMF e AI Act |

| Cultura e Responsabilidade | Engajamento com ética e inovação | Alienação dos times, resistência interna |

O que é um roadmap de IA — e por que o conselho deve acompanhar

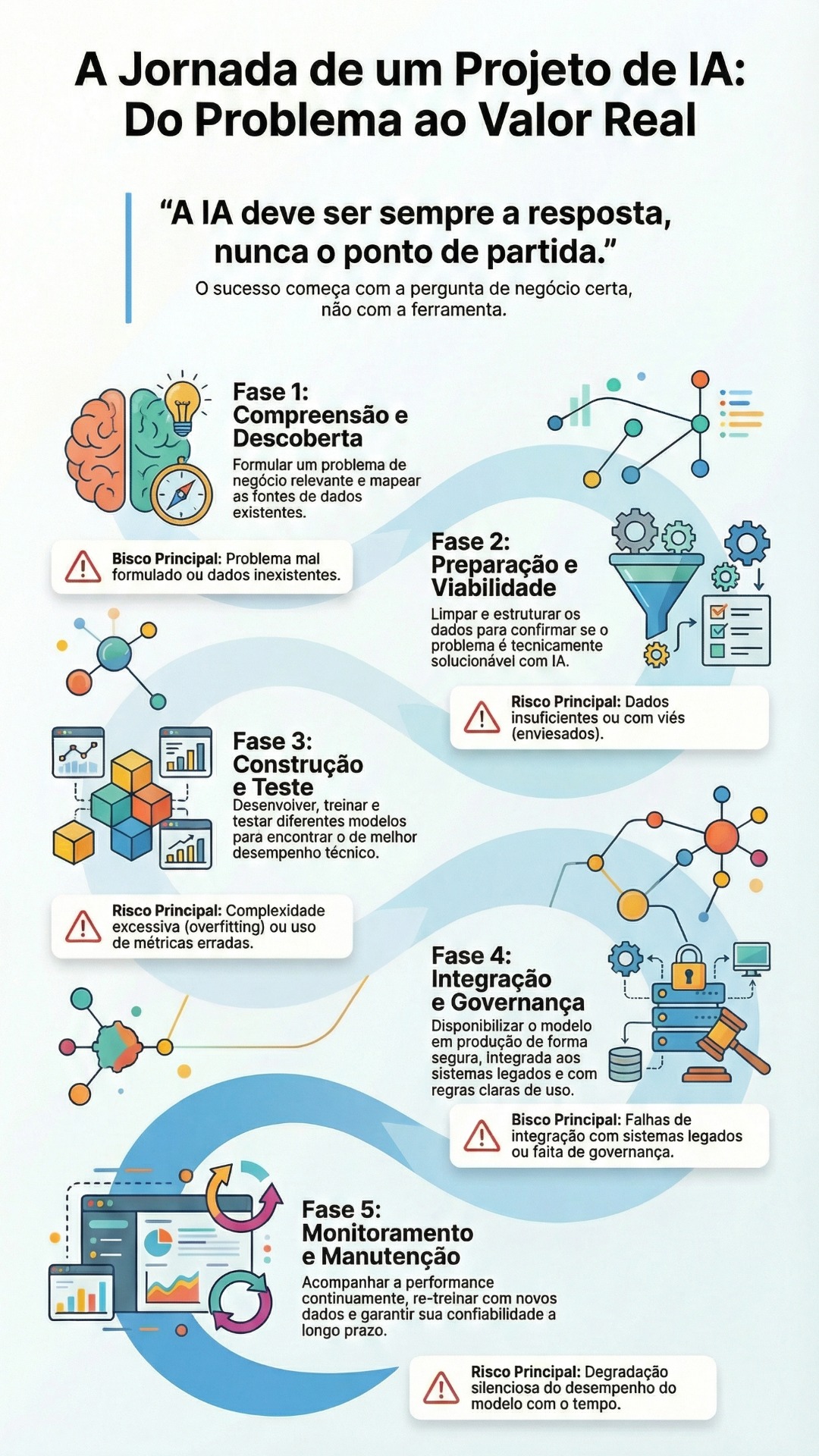

Para a maioria das organizações, a adoção de inteligência artificial é uma jornada — e não um salto. Não se trata apenas de “implementar IA”, mas de percorrer uma trilha estratégica que começa com experimentos e evolui para soluções escaláveis, confiáveis e alinhadas ao negócio. Essa trilha é o que chamamos de roadmap de IA.

Um roadmap bem estruturado organiza os esforços de IA ao longo do tempo, define marcos de maturidade e integra aspectos técnicos, culturais, organizacionais e de governança. É uma ferramenta essencial para conselheiros, pois permite avaliar a consistência dos investimentos, a ambição estratégica e os mecanismos de controle associados ao uso da IA.

O modelo da Gartner: sete dimensões do roadmap

A consultoria Gartner propõe um modelo robusto e prático para estruturar o roadmap de IA. Esse modelo organiza a jornada de adoção de IA em quatro estágios de maturidade (de “no value” a “value at scale”) e sete trilhas complementares que devem evoluir de forma integrada:

As sete trilhas ou dimensões principais são:

1. AI Strategy (Estratégia de IA)

2. AI Value (Geração de Valor)

3. AI Organization (Organização para IA)

4. AI People and Culture (Pessoas e Cultura)

5. AI Governance (Governança de IA)

6. AI Engineering (Engenharia de IA)

7. AI Data (Dados para IA)

Essas dimensões são interdependentes. Uma estratégia sem estrutura organizacional não avança. Um modelo técnico sem dados confiáveis falha. E uma cultura organizacional resistente pode barrar qualquer avanço. Por isso, é importante que conselheiros tenham clareza não apenas sobre os projetos em execução, mas sobre a coerência e sincronização entre esses sete eixos.

O que o conselho deve observar em cada dimensão

A seguir, apresentamos uma tabela-resumo com os sete pilares do roadmap e os principais pontos que conselheiros devem observar em cada um deles. A tabela pode ser usada como um instrumento de avaliação periódica ou checklist estratégico.

Tabela-resumo: Sete dimensões do roadmap de IA (segundo Gartner)

| Dimensão | O que representa | O que o conselho deve observar |

| 1. Estratégia de IA (AI Strategy) | Clareza da visão e alinhamento com os objetivos do negócio | A empresa possui uma estratégia formalizada de IA? Está integrada ao planejamento estratégico? |

| 2. Geração de Valor (AI Value) | Mecanismos para gerar, mensurar e escalar valor com IA | Há indicadores de sucesso? Como o retorno sobre investimento está sendo medido? |

| 3. Organização para IA (AI Organization) | Estrutura, processos e responsabilidades para viabilizar projetos | Existe uma governança clara entre áreas técnicas, jurídicas e de negócio? |

| 4. Pessoas e Cultura (AI People and Culture) | Capacitação, engajamento e gestão da mudança organizacional | Os colaboradores entendem o papel da IA? Há programas de formação e sensibilização? |

| 5. Governança de IA (AI Governance) | Regras, papéis e mecanismos de controle ético e operacional | A empresa possui princípios éticos, comitês ou protocolos para IA responsável? |

| 6. Engenharia de IA (AI Engineering) | Infraestrutura técnica e boas práticas para escalar soluções | As soluções seguem padrões de segurança, escalabilidade e integração com sistemas legados? |

| 7. Dados para IA (AI Data) | Qualidade, acessibilidade e governança dos dados utilizados | Há gestão dos dados (governança, curadoria, privacidade)? Os dados são confiáveis e auditáveis? |

Essa visão integrada permite que conselheiros não se percam em detalhes técnicos, mas foquem em perguntas-chave de alto nível:

- Estamos investindo em IA com uma visão clara de futuro ou apenas por modismo?

- Como essa tecnologia se conecta aos resultados esperados da empresa?

- Temos mecanismos para prevenir vieses, garantir explicabilidade e auditar decisões automatizadas?

- Estamos preparando nossa força de trabalho — e a cultura organizacional — para conviver com IA?

Ao acompanhar de perto o roadmap de IA, o conselho deixa de ser um mero espectador e passa a ser um agente ativo na construção do futuro digital da organização.

Governança de IA: Fundamentos para conselhos responsáveis

Com a adoção crescente de soluções baseadas em inteligência artificial, o papel da governança organizacional se expande para territórios ainda pouco explorados. Se antes os conselhos concentravam sua atenção em estruturas tradicionais como a governança corporativa, de TI e de riscos, agora precisam incorporar uma nova camada: a governança da inteligência artificial.

Esse novo campo exige não apenas adaptar controles já existentes, mas repensar princípios, estruturas e métricas — pois os riscos, os impactos e as responsabilidades da IA são distintos dos sistemas convencionais.

Diferença entre governança tradicional e governança de IA

A governança tradicional parte do pressuposto de que processos, controles e responsabilidades são previsíveis e lineares. Sistemas são auditáveis, seus resultados são rastreáveis, e suas falhas geralmente derivam de causas humanas identificáveis. Já a governança de IA lida com um novo tipo de desafio: sistemas que aprendem, mudam e tomam decisões autônomas, baseados em dados que muitas vezes os próprios humanos não conseguem interpretar totalmente.

Isso altera profundamente os fundamentos da supervisão. Um modelo de machine learning pode ser treinado com vieses invisíveis, agir de forma discriminatória sem intenção explícita, ou gerar resultados que mesmo seus desenvolvedores não conseguem explicar integralmente. Tais características tornam insuficiente o uso exclusivo das ferramentas tradicionais de governança.

A literatura atual aponta que a governança de IA deve considerar desde a fase de desenvolvimento até o uso contínuo do sistema, exigindo papéis e mecanismos próprios, como: comitês éticos de IA, responsáveis por auditoria algorítmica, registros de decisões automatizadas e revisão periódica de impactos sociais .

Princípios centrais da governança de IA

O consenso internacional tem convergido em torno de cinco princípios fundamentais que orientam a boa governança da IA. Estes princípios não apenas orientam desenvolvedores e gestores, mas devem guiar também a atuação do conselho:

- Transparência: A organização deve ser capaz de explicar o que os sistemas fazem, como fazem e por quê. Isso inclui documentação técnica, rastreabilidade de decisões e abertura a auditorias externas.

- Responsabilidade (Accountability): É essencial que se defina quem responde por cada sistema de IA: seja em caso de erro, violação ética ou descumprimento legal. Isso inclui atribuição clara de papéis e políticas de uso responsável.

- Explicabilidade: Além de transparência técnica, os resultados da IA devem ser compreensíveis por não-especialistas, especialmente quando impactam clientes, funcionários ou cidadãos. É o princípio da “inteligibilidade organizacional”.

- Segurança: Refere-se tanto à segurança cibernética (proteção contra ataques) quanto à robustez dos modelos frente a falhas e manipulações. Modelos precisam ser monitorados em tempo real, com planos de contingência e rollback.

- Justiça: A IA deve ser concebida para evitar discriminação algorítmica, garantindo tratamento justo e equitativo entre indivíduos e grupos. Isso exige análise contínua de dados de entrada, métricas de impacto e mecanismos de correção.

Esses princípios têm sido reiterados em documentos como o NIST AI Risk Management Framework e o AI Act da União Europeia, que destacam a necessidade de integrá-los ao ciclo de vida completo dos sistemas inteligentes — da concepção à desativação.

O papel do conselho na integração com as outras estruturas de governança

Governar a IA não deve ser visto como uma tarefa isolada ou técnica. Trata-se de uma responsabilidade estratégica, que precisa estar conectada às estruturas existentes de governança corporativa, de tecnologia da informação e de dados. Esse alinhamento é fundamental para garantir coerência organizacional e evitar lacunas de controle.

O artigo Defining Organizational AI Governance and Ethics, de Weihrauch e Wu, propõe que a governança de IA deve ser integrada formalmente ao modelo de governança corporativa, com canais de reporte claros para o board e interfaces com os comitês de risco, jurídico e compliance.

Assim, o conselho deve:

- Garantir que exista uma política formal de IA responsável aprovada no nível corporativo;

- Solicitar relatórios periódicos de risco e impacto dos sistemas de IA implantados;

- Validar que o uso de IA está coberto pelas auditorias internas e por estruturas de compliance;

- Verificar a existência de um comitê de IA ou equivalente com autoridade real e poder decisório.

Por fim, cabe aos conselheiros promover a convergência dos marcos normativos internos com as tendências regulatórias globais, antecipando riscos e criando vantagens competitivas baseadas em confiança.

Como avaliar o estágio de maturidade do roadmap de IA

Para exercer seu papel de forma eficaz, o conselho de administração precisa entender onde a organização se encontra na jornada da inteligência artificial. Isso não exige domínio técnico, mas sim clareza sobre o nível de maturidade dos processos, capacidades e governança relacionados à IA.

Essa avaliação permite reconhecer riscos, detectar desalinhamentos e identificar oportunidades de evolução. E, acima de tudo, dá ao conselho um instrumento de supervisão e tomada de decisão estruturada.

Três estágios de maturidade

A jornada de adoção de IA pode ser sintetizada em três grandes estágios, aplicáveis às sete dimensões do roadmap (ver Tabela 1). A seguir, apresentamos uma tabela de autoavaliação que pode ser utilizada em reuniões estratégicas ou comitês específicos, sempre com foco em orientar e não apenas diagnosticar.

Tabela – Matriz de avaliação da maturidade em IA

| Dimensão | Iniciante | Intermediário | Avançado |

| Estratégia | Sem visão clara; iniciativas desconectadas | Visão emergente, alinhada à TI | Estratégia integrada ao plano de negócios |

| Geração de valor | Sem métricas de ROI; projetos isolados | Métricas parciais e planos piloto em execução | ROI monitorado; valor gerado em escala |

| Organização | Falta de estrutura e de papéis definidos | Núcleo de IA criado, mas com baixa integração | Estrutura formal, com liderança e KPIs claros |

| Pessoas e cultura | Resistência e desconhecimento | Iniciativas de capacitação em curso | Cultura orientada por dados e IA disseminada |

| Governança de IA | Inexistente ou informal | Normas básicas e responsáveis nomeados | Comitê de IA ativo, políticas formais, auditoria contínua |

| Engenharia de IA | Sem infraestrutura dedicada | Ambiente de testes disponível | Integração com sistemas, pipelines escaláveis |

| Dados para IA | Dados dispersos, sem curadoria | Projetos de catalogação e saneamento em curso | Governança de dados consolidada e acessível |

Sinais de alerta e boas práticas

Durante o processo de avaliação, conselheiros devem estar atentos a alguns sinais críticos que indicam desequilíbrio no avanço das trilhas do roadmap:

Sinais de alerta:

- Projetos de IA que avançam sem coordenação com estratégia de negócios.

- Ausência de responsáveis formais por riscos ou impactos algorítmicos.

- Uso de dados sensíveis sem mecanismos de controle ou anonimização.

- Falta de métricas claras para medir resultados de IA.

- TI sobrecarregada com demandas não estruturadas de modelos.

Boas práticas emergentes:

- Revisão trimestral do roadmap de IA com participação do board.

- Comitês interdisciplinares com representantes de negócio, tecnologia, jurídico e RH.

- Indicadores de impacto social, ambiental ou ético junto aos KPIs técnicos.

- Uso de painéis de acompanhamento com visão integrada das dimensões do roadmap.

Essas práticas ajudam a equilibrar velocidade e responsabilidade, promovendo a evolução sustentada da organização no uso estratégico da IA.

Checklist para conselheiros

Para facilitar a atuação prática do conselho, segue um checklist com perguntas que podem orientar reuniões com executivos, revisões de projetos e comitês de risco:

Checklist de avaliação do roadmap e da governança de IA

| Dimensão | Perguntas-chave para conselheiros |

| Estratégia | A empresa possui um documento estratégico formal para IA? |

| A estratégia de IA está alinhada aos objetivos de médio e longo prazo? | |

| Valor e Resultados | Há métricas de sucesso definidas para os projetos de IA? |

| Existem planos para escalar as soluções que geram valor comprovado? | |

| Governança | Há responsáveis formais pela supervisão dos projetos e riscos de IA? |

| Existem políticas éticas, critérios de explicabilidade e mecanismos de auditoria ativos? | |

| Riscos e Compliance | Os sistemas de IA estão aderentes à LGPD e demais normas setoriais? |

| A organização considera marcos como o NIST AI RMF ou o EU AI Act? | |

| Organização e Cultura | A equipe está preparada para lidar com IA? Há programas de capacitação e cultura de dados? |

| Existem resistências internas significativas? Elas estão sendo endereçadas? | |

| Dados | Os dados utilizados são atualizados, auditáveis e protegidos adequadamente? |

| Existe uma governança formal sobre o uso e a curadoria dos dados para IA? | |

| Engenharia | A infraestrutura atual é suficiente para operar e escalar modelos com segurança? |

| Existem práticas de MLOps adotadas (monitoramento, versionamento, automação)? |

Esse checklist pode ser incorporado aos rituais de governança do conselho, como parte de sua agenda de supervisão de riscos estratégicos e inovação. O uso contínuo dessa ferramenta ajuda a transformar a complexidade da IA em decisões estratégicas bem fundamentadas.

Estrutura mínima de governança de IA a ser exigida

Para que os conselhos possam exercer seu papel de supervisão estratégica, é essencial que a organização disponha de uma estrutura de governança de IA clara, funcional e integrada às demais estruturas corporativas. Essa estrutura não precisa ser complexa ou custosa no início, mas deve contemplar papéis bem definidos, mecanismos de controle efetivos e canais de comunicação entre áreas técnicas e instâncias decisórias.

A ausência de governança adequada não apenas compromete o sucesso técnico dos projetos de IA, mas expõe a organização a riscos éticos, regulatórios, reputacionais e até judiciais.

Comitês, papéis e responsabilidades essenciais

A primeira exigência para uma governança eficaz de IA é a definição clara de quem é responsável pelo quê. Isso inclui não apenas a liderança de projetos, mas também a supervisão ética, técnica e institucional.

Os seguintes elementos formam o núcleo mínimo recomendado:

- Chief AI Officer (CAIO): Responsável por coordenar a estratégia de IA da organização. Atua como ponto focal entre áreas técnicas, executivas e regulatórias. Pode estar vinculado à diretoria de tecnologia ou operar em paralelo, com assento em comitês estratégicos.

- Comitê de Ética em IA: Grupo multidisciplinar que inclui representantes das áreas de negócio, jurídico, tecnologia, compliance e, quando possível, stakeholders externos. Sua função é revisar projetos críticos, aprovar diretrizes éticas e acompanhar impactos sociais, ambientais e reputacionais.

- Responsável por MLOps: Um papel técnico central na operação contínua da IA. Cuida de práticas como versionamento de modelos, monitoramento de desempenho, atualização segura e documentação. Esse papel é vital para garantir que modelos em produção se mantenham alinhados às expectativas iniciais e às regras da organização .

- Representantes de áreas reguladas: Em setores como saúde, finanças ou energia, é fundamental que as áreas regulatórias e jurídicas estejam presentes desde a concepção de projetos, reduzindo retrabalho e riscos de não conformidade.

Essa estrutura pode começar de forma enxuta, mas deve crescer à medida que a IA se torna mais presente nas decisões críticas da organização.

Integração com compliance, jurídico e auditoria interna

Uma boa governança de IA não opera isoladamente. Pelo contrário, ela se conecta diretamente às funções de compliance, jurídico e auditoria interna. Esses vínculos garantem que os princípios éticos e legais da organização se traduzam em práticas concretas no ciclo de vida dos sistemas inteligentes.

- Compliance deve incorporar cláusulas específicas sobre IA em seus códigos de conduta e políticas de uso de tecnologia.

- Jurídico precisa estar envolvido na avaliação de contratos com fornecedores de IA, na adequação à LGPD e nas obrigações do EU AI Act ou legislações equivalentes.

- Auditoria interna deve atuar de forma contínua, auditando não apenas os resultados dos sistemas, mas também os processos de treinamento, validação, uso de dados e manutenção de modelos.

Essa integração evita que a IA se transforme em uma “zona cinzenta” da organização — operando fora do alcance das estruturas tradicionais de controle.

Mecanismos de auditoria, monitoramento e resposta a incidentes

Um ponto frequentemente negligenciado, mas crítico para o conselho, é a existência de mecanismos formais de monitoramento, auditoria e resposta a incidentes algorítmicos.

Elementos fundamentais incluem:

- Inventário de sistemas de IA em uso: Um repositório atualizado que descreve quais modelos estão em produção, com que propósito, quem é o responsável e quais dados são utilizados.

- Protocolos de auditoria algorítmica: Avaliações periódicas da performance, vieses e conformidade dos modelos. Essas auditorias devem ser documentadas e reportadas ao comitê de ética ou ao conselho.

- Monitoramento contínuo (observabilidade de IA): Ferramentas que acompanham em tempo real o desempenho dos modelos, detectando desvios, degradação de acurácia ou falhas de generalização.

- Procedimentos de rollback e contingência: Caso um modelo falhe ou gere um resultado inaceitável, é essencial que exista um processo definido de substituição, revisão ou interrupção segura.

- Canal de denúncia e resposta a incidentes: Empregados, fornecedores e até clientes devem ter um canal para relatar comportamentos inesperados ou injustos gerados por IA. Isso reforça a cultura de confiança e a vigilância ética.

Em setores sensíveis, esses mecanismos já estão sendo exigidos por reguladores. Mas mesmo onde ainda não são mandatórios, a sua implementação antecipa exigências futuras e protege a reputação da organização.

Como orientar executivos para garantir valor e ética

A principal responsabilidade do conselho não é projetar algoritmos nem escolher frameworks técnicos — mas garantir que as decisões relacionadas à inteligência artificial estejam alinhadas aos valores, à estratégia e à responsabilidade corporativa da organização. Isso exige um novo tipo de diálogo entre conselheiros e executivos, pautado por princípios éticos traduzidos em práticas de gestão concretas.

Transformar ética em ação não é tarefa trivial. Princípios como transparência, justiça e explicabilidade são amplamente aceitos, mas sua operacionalização exige escolhas difíceis e, muitas vezes, compromissos entre eficiência, risco e reputação.

Como transformar princípios éticos em práticas de gestão

Para garantir que os princípios não se tornem apenas declarações genéricas, é necessário integrá-los diretamente ao ciclo de vida dos projetos de IA. O conselho pode orientar os executivos a adotar práticas como:

- Políticas formais de IA responsável, com diretrizes claras desde a concepção até a desativação dos sistemas;

- Critérios de avaliação ética nos processos de aprovação de novos projetos;

- Indicadores de desempenho ético, como número de incidentes, acurácia diferencial entre grupos, ou volume de modelos com documentação completa;

- Treinamentos em vieses, explicabilidade e impacto social para desenvolvedores, gestores e usuários de IA;

- Auditorias internas e externas regulares, com foco não apenas em performance técnica, mas também em equidade, governança e conformidade.

Ao exigir que os executivos traduzam princípios em instrumentos de gestão, o conselho fortalece o valor da IA como ativo estratégico — e não apenas como recurso técnico.

Perguntas-chave que o conselho deve fazer

Uma das formas mais eficazes de atuação do conselho é por meio de perguntas estruturantes, capazes de revelar riscos ocultos, fragilidades éticas e oportunidades de melhoria. Abaixo, uma seleção de perguntas que devem ser incorporadas à pauta dos comitês de inovação, risco e compliance:

Estratégia e valor

- Como este projeto de IA se conecta à estratégia da organização?

- Que resultados são esperados — e como serão medidos?

- Há plano para escalar a solução ou ela permanecerá como piloto?

Ética e responsabilidade

- Que vieses podem surgir neste modelo? Como serão detectados e corrigidos?

- Há plano de explicabilidade para usuários internos e externos?

- O modelo pode ser auditado? Existe documentação adequada?

- O sistema permite intervenção humana em decisões críticas?

Governança e integração

- Quem é o responsável final por este sistema de IA?

- Quais áreas foram consultadas durante o desenvolvimento (jurídico, compliance, diversidade, RH)?

- Os dados utilizados estão em conformidade com a LGPD e políticas internas?

Essas perguntas ajudam o conselho a manter o controle estratégico e ético da IA sem precisar entrar nos detalhes técnicos. Elas também estimulam os executivos a desenvolver projetos mais robustos e alinhados à cultura organizacional.

Exemplos de decisões difíceis: ética na prática

Mesmo com políticas e estruturas bem definidas, muitas decisões relacionadas à IA envolvem dilemas reais, em que não há respostas perfeitas. O papel do conselho, nesses casos, é garantir que as decisões levem em conta múltiplas perspectivas e não comprometam a integridade institucional.

Exemplo 1 – Performance vs. justiça algorítmica

Um modelo de crédito apresenta alta acurácia, mas exclui de forma sistemática candidatos de determinados bairros com renda mais baixa. Corrigir o viés pode reduzir a performance preditiva, mas manter o modelo como está pode implicar em discriminação indireta.

O conselho deve perguntar: quais critérios serão priorizados? A reputação institucional está protegida? Há risco regulatório?

Exemplo 2 – Explicabilidade vs. inovação técnica

Uma equipe deseja implantar um modelo de deep learning de última geração, com alta performance, mas pouca explicabilidade. A área de compliance alerta que a solução pode dificultar a transparência com clientes e reguladores.

O conselho pode solicitar: o modelo pode ser substituído por uma versão mais transparente? É possível adotar um método de explicabilidade pós-hoc?

Exemplo 3 – Automação vs. supervisão humana

Uma área operacional quer automatizar 100% de uma decisão crítica (por exemplo, aprovação de pedidos médicos ou liberação de seguros). A proposta elimina intervenção humana por completo.

O conselho deve discutir: há risco de erro grave ou injustiça? É aceitável eliminar o fator humano? O sistema prevê reversibilidade de decisões?

Esses casos ilustram como a ética da IA não é teórica, mas profundamente prática. E como o conselho tem um papel insubstituível em garantir que a empresa faça escolhas conscientes e consistentes com seus valores.

Exemplos práticos e aprendizados globais

A melhor forma de compreender os desafios e oportunidades da governança de IA é observar como empresas líderes no uso de tecnologia têm estruturado suas jornadas — com sucessos, ajustes e, em alguns casos, falhas emblemáticas. Nesta seção, apresentamos três exemplos com base no modelo AI-C2C (Conscious to Conscience), que propõe uma jornada evolutiva em três estágios:

- Adoção consciente da IA;

- Colaboração entre IA e inteligência humana;

- Governança ética consolidada.

Esse modelo tem sido aplicado em empresas como IBM, AstraZeneca e Mastercard, permitindo identificar boas práticas replicáveis — e lacunas que merecem atenção dos conselhos.

Caso 1 – IBM: IA com foco em confiança e padronização

A IBM tem sido uma das pioneiras em estruturar políticas internas de governança de IA. Criou um comitê global de ética em IA, publicou seus princípios de uso responsável e desenvolveu uma ferramenta própria de explicabilidade e avaliação de risco algorítmico.

Além disso, a empresa incorporou práticas como:

- Classificação de projetos por grau de risco (regulatório, reputacional, ético);

- Auditorias regulares de modelos com base em métricas de fairness;

- Inclusão do Chief AI Ethics Officer nos comitês executivos.

Lição para conselhos: transparência e explicabilidade não são obstáculos à inovação — são aceleradores de confiança em ambientes regulados.

Caso 2 – AstraZeneca: IA no coração da tomada de decisão clínica

A farmacêutica global adotou IA para acelerar processos de descoberta de medicamentos e diagnóstico clínico assistido. Para isso, estruturou um modelo de governança baseado em:

- Comitês de revisão técnica e ética antes da aprovação de novos modelos;

- Integração entre equipes de dados, compliance, regulação sanitária e bioética;

- Avaliação do impacto social dos algoritmos aplicados à saúde.

Em um dos projetos-piloto, um algoritmo clínico inicialmente promissor foi suspenso após os testes apontarem uma tendência de menor precisão em populações negras e asiáticas. A suspensão foi acompanhada de um plano de correção de viés e novo protocolo de validação com diversidade demográfica ampliada.

Lição para conselhos: é preciso garantir que os sistemas não apenas entreguem bom desempenho, mas que também o façam de forma justa — especialmente quando impactam vidas humanas

Caso 3 – Mastercard: IA integrada à governança corporativa

A Mastercard desenvolveu um programa de IA responsável baseado no modelo AI-C2C, com destaque para:

- Um comitê de IA subordinado ao Comitê de Risco e Conformidade do conselho;

- Treinamentos internos obrigatórios sobre ética em algoritmos;

- Avaliação cruzada entre áreas técnicas e jurídicas antes de lançar produtos baseados em IA.

A empresa também desenvolveu um framework interno de maturidade em IA, permitindo que cada unidade de negócio seja avaliada periodicamente em aspectos como explicabilidade, governança de dados, equidade e auditabilidade.

Lição para conselhos: incluir a IA na agenda dos comitês de risco, compliance e inovação permite prevenir falhas e gerar valor com maior segurança jurídica e institucional.

Lições aprendidas sobre falhas de governança

Além dos casos positivos, o histórico recente traz alertas importantes. Em diversos setores, falhas de governança em IA resultaram em crises reputacionais, ações judiciais e até sanções de agências reguladoras. Entre os principais aprendizados:

- Falta de supervisão independente: quando os times técnicos são os únicos responsáveis por avaliar riscos éticos, há risco de “visão de túnel”. Conselhos precisam garantir que haja instâncias de controle externas à área de dados.

- Ausência de validação pré-uso: sistemas colocados em produção sem testes éticos ou de vieses tendem a replicar desigualdades históricas. O board deve exigir revisões prévias e validações multiculturais.

- Desconexão entre áreas técnicas e jurídicas: falhas de governança emergem quando os times de IA desenvolvem soluções sem consultar compliance ou jurídico, especialmente em setores regulados.

- Foco exclusivo em performance técnica: organizações que priorizam acurácia e retorno financeiro, ignorando aspectos sociais, frequentemente enfrentam desgaste reputacional — muitas vezes irreversível.

Esses exemplos demonstram que a governança de IA não é um diferencial competitivo opcional — é uma blindagem estratégica e ética. Cabe ao conselho garantir que o aprendizado global seja traduzido em práticas internas, com apoio de comitês técnicos, indicadores e cultura organizacional.

O papel futuro dos conselhos: da supervisão ao direcionamento estratégico

À medida que a inteligência artificial se torna parte integrante da estratégia e da operação das empresas, os conselhos de administração precisam evoluir de uma postura reativa de supervisão para um papel proativo de direcionamento estratégico. A IA já não é uma tecnologia periférica — ela redefine mercados, modelos de negócios e a própria dinâmica da confiança entre empresas e sociedade.

Neste novo cenário, o conselho passa a ser o guardião da confiança digital. É ele quem deve garantir que o uso de tecnologias inteligentes esteja a serviço da estratégia, da ética e da sustentabilidade da organização no longo prazo.

Conselheiros como guardiões da confiança digital

Confiança é o ativo mais valioso de uma organização na era da IA. Não basta entregar soluções eficazes — é preciso garantir que sejam seguras, justas, transparentes e auditáveis. Essa responsabilidade não pode ser delegada integralmente aos times técnicos. Cabe ao conselho zelar por uma governança que assegure à sociedade, aos clientes, aos reguladores e aos próprios colaboradores que a empresa opera com responsabilidade algorítmica.

Ser guardião da confiança digital significa:

- Estimular a adoção ética de tecnologias avançadas;

- Antecipar riscos reputacionais e legais;

- Garantir a coerência entre inovação e valores institucionais;

- Reforçar a cultura de prestação de contas no uso de IA.

Isso posiciona o conselho como protagonista na transição para um modelo de negócios orientado por inteligência, mas ancorado na integridade.

Capacitação do conselho em temas de IA

Para exercer esse novo papel, os conselheiros precisam adquirir fluência básica em temas relacionados à IA. Não se trata de aprender a programar ou dominar arquiteturas de redes neurais, mas de compreender:

- O ciclo de vida de sistemas de IA e seus riscos;

- Conceitos como vieses algorítmicos, explicabilidade, fairness e auditabilidade;

- As implicações regulatórias da LGPD, do NIST AI RMF, do EU AI Act e de legislações emergentes;

- Os limites éticos da automação em diferentes contextos (RH, crédito, saúde, segurança, etc.).

Algumas empresas têm optado por incluir especialistas em IA em seus conselhos ou criar programas internos de educação executiva. Outras têm promovido workshops práticos e discussões éticas simuladas, com participação de stakeholders externos, como reguladores, acadêmicos ou organizações da sociedade civil.

Investir na capacitação do conselho é uma forma de alinhar o board às transformações do negócio — e reduzir a assimetria de conhecimento que muitas vezes impede uma supervisão eficaz.

Mecanismos de atualização contínua e formação de comitês especializados

Como a tecnologia avança rapidamente, a capacitação não pode ser pontual. O ideal é que os conselhos estabeleçam mecanismos de atualização contínua, tais como:

- Painéis periódicos com especialistas e fornecedores estratégicos;

- Participação em fóruns de inovação e governança tecnológica;

- Relatórios trimestrais de riscos emergentes em IA, apresentados pelos executivos;

- Acompanhamento das tendências regulatórias nacionais e internacionais.

Além disso, é recomendável a formação de comitês especializados em IA e tecnologia, com funções como:

- Acompanhar projetos estratégicos de IA em tempo real;

- Supervisionar políticas de uso responsável e indicadores de risco;

- Avaliar aquisições e parcerias tecnológicas sob a ótica da governança e da ética.

Esses comitês não substituem o conselho, mas reforçam sua capacidade de avaliar tecnicamente temas complexos, oferecendo recomendações embasadas para a tomada de decisão estratégica.

Ao assumir essa agenda com protagonismo, o conselho deixa de ser um mero fiscal de conformidade e se posiciona como agente ativo da transformação digital responsável, impulsionando valor com consciência e visão de longo prazo.

Conclusão e próximos passos

A inteligência artificial não é apenas mais uma tecnologia a ser supervisionada: ela altera os fundamentos da tomada de decisão, da gestão de risco e da geração de valor nas organizações. Diante disso, o conselho de administração tem um novo papel — e uma responsabilidade ampliada.

Ao longo deste guia, destacamos que a atuação do conselho deve evoluir da supervisão técnica para o direcionamento estratégico da IA com base em princípios éticos, estrutura de governança e geração sustentável de valor.

Recapitulação das responsabilidades essenciais do conselho

- Alinhar a IA à estratégia da organização, garantindo que os investimentos estejam integrados aos objetivos de longo prazo.

- Exigir a construção de um roadmap estruturado, com planos, métricas e evolução clara nas sete dimensões críticas.

- Estabelecer padrões mínimos de governança de IA, incluindo comitês, papéis e processos para supervisão ética e técnica.

- Promover o uso responsável da IA, garantindo que modelos sejam auditáveis, explicáveis e justos.

- Capacitar-se continuamente em temas de IA, reduzindo a assimetria de conhecimento e fortalecendo a tomada de decisão.

- Integrar a IA à governança corporativa existente, conectando áreas como compliance, jurídico, auditoria interna e tecnologia.

Essas responsabilidades não devem ser tratadas como demandas adicionais, mas como parte integrante do dever fiduciário de proteger a organização e seus stakeholders.

Recomendações práticas imediatas

Para transformar esse posicionamento estratégico em ação concreta, o conselho pode iniciar com cinco movimentos prioritários:

- Solicitar um diagnóstico da maturidade em IA da organização, utilizando frameworks como o apresentado neste artigo.

- Incluir a pauta de IA na agenda regular do conselho, conectando-a aos comitês de risco, inovação e ESG.

- Instituir um Comitê de IA ou designar conselheiro responsável, com interface direta com o Chief AI Officer (se houver).

- Revisar a política de governança corporativa, incluindo princípios específicos para uso ético e responsável da IA.

- Participar de formações e painéis sobre IA para conselheiros, promovendo o aprendizado coletivo e a atualização constante.

Essas ações podem ser iniciadas independentemente do estágio atual da empresa. O importante é construir uma trilha de avanço contínuo e deliberado.

Convite à ação: Seu conselho está preparado?

A velocidade da transformação digital exige uma postura proativa dos conselhos. A IA deixará marcas profundas na reputação, no valor de mercado e na sustentabilidade das organizações. Os conselhos que assumirem seu papel desde agora terão mais controle, mais resiliência e mais credibilidade frente aos reguladores, à sociedade e aos investidores.

Seu conselho está preparado para orientar a organização na era da inteligência artificial?

Se a resposta ainda for “não”, este é o momento de agir.

O futuro será moldado por decisões que estão sendo tomadas hoje — e a inteligência que as orienta precisa ser não apenas artificial, mas também ética, estratégica e humana.