A mudança de comportamento dos consumidores e o avanço da tecnologia destruirá o atual modelo de Contact Center. Os consumidores da geração Z, nascidos a partir da década de 90 e na totalmente envolvidos com a Internet e redes sociais, substituíram a comunicação de voz unívoca pela comunicação de dados de um para muitos. Atingir esse consumidor com antigas técnicas de telemarketing é desperdiçar recursos. Em paralelo e em grande velocidade, os avanços da tecnologia superam as expectativas dos mais otimistas. Esses dois fatores exigem um total redesenho do modelo de relacionamento com os clientes. O desafio é gigantesco para empresas com milhões de clientes, com milhares de atendentes no Contact Center e que operam em mercados regulados, tais como distribuição de energia, telecomunicações e mercado financeiro. Essa transformação impacta diretamente a economia de regiões que se desenvolveram a partir da especialização em serviços de Contact Center, como Índia, Canadá, Irlanda e alguns países da América Central. Acabam também restringindo o acesso ao primeiro emprego de jovens com baixa qualificação profissional. Por outro lado, abre enormes oportunidades para novas funções especializadas e de melhor remuneração, tais como cientistas de dados e treinadores de computadores.

Minha percepção é que as áreas de marketing e operação de Contact Center estão tão envolvidas nas frenéticas atividades do dia a dia que não analisam em profundidade a próxima onda do relacionamento com os clientes. Muitos já identificaram o inicio dessa transformação, porém não conseguem mensurar o tempo que o atual modelo ainda sobreviverá. Essa falta de horizonte tangível faz com que os investimentos sejam canalizados para a expansão do atual modelo. Quando mais se investe no modelo antigo, maiores serão os investimentos no futuro para se adequar ao novo cenário de relacionamento com os clientes.

A curva de adoção de novas tecnologias por pessoas de outras gerações é exponencial. Quem não conhece uma vovó que se relaciona com seus netos via WhatsApp, Skype e Facebook? Falharão as empresas que adotam um modelo de inovação evolutivo em mercados onde as transformações são disruptivas.

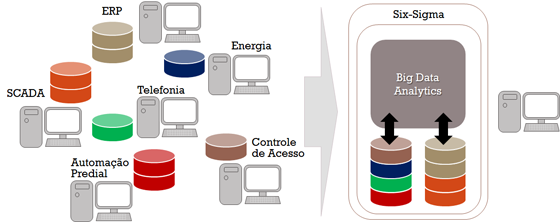

Para a maioria das empresas o uso de redes sociais para relacionamento com clientes ainda está na fase de experimentação. O uso das redes sociais é pontual e as analises não são integradas. Apesar da Google operar em ambiente Big Data há mais de 10 anos, poucas empresas aproveitam essa experiência para alavancar seus negócios. Mesmo considerando que muitos dos softwares são open source e que algumas aquisições de dados são gratuitas, como o caso do Twitter.

Há pouco tempo atrás tratado como ficção cientifica, hoje um computador que escuta, interpreta, busca e processa informações e estabelece um dialogo em linguagem natural com as pessoas é uma realidade acessível a qualquer empresa como serviço na nuvem. A IBM vende como serviço o acesso ao supercomputador Watson, que entre outros feitos venceu o enxadrista campeão mundial Kasparov, na versão anterior chamado Deep Blue, e recentemente superou dois campeões americanos do jogo Jeopardy!, onde os participantes escutam dicas sobre um assunto e devem fazer a pergunta certa.

Integrar as novas tecnologias e as montanhas de informações que elas oferecem a partir de dados publicados pelos próprios clientes nas redes sociais e outros dados de relacionamento direto com a empresa, como compras recentes e visitas a páginas de produtos, requer um novo perfil de profissional, o cientista de dados. Esse profissional deve ter profundos conhecimentos de modelagem de dados, modelos matemáticos, tecnologia da informação, comportamento do consumidor e visão aguçada para novos negócios.

Outra função importante nesse contexto é o treinador de computadores. Os softwares de Inteligência Artificial precisam aprender a analisar corretamente os dados que recebem para tomar decisões corretas. Para isso, deverá contar com a ajuda de um humano para ensiná-lo e corrigir os desvios de interpretação. Por exemplo, no primeiro de Abril de 2015, a fabricante de carros elétricos Tesla Motors, fez uma inocente pegadinha que provocou grandes oscilações financeiras. Ao anunciar um tal Model W, um suposto relógio no dia da mentira, ficava claro para quem via a foto e o anúncio que se tratava de uma brincadeira com o Apple Watch. Entretanto, os sistemas automáticos de compra e venda de ações baseados em algoritmos matemáticos não entenderam a piada e fizeram as ações da empresa subir US$1,5 em apenas um minuto, sendo negociados quase 400 mil papéis.

A convergência da transformação dos consumidores e avanço da tecnologia irá dizimar milhões de empregos no mundo. O mercado de Contact Center no Brasil emprega 1,8 milhões de profissionais, onde cerca de 660 mil são terceirizados, sendo um dos maiores geradores de emprego no mercado. Entretanto, é um setor de baixa remuneração com um ganho médio de R$706 por mês, para um período diário de 6 horas e 20 minutos, com dois intervalos de 10 minutos.

Esse novo cenário exige ações imediatas de planejamento das empresas que operam grandes Contact Centers e revisão de suas estratégias de relacionamento com clientes. As empresas deverão formar profissionais para novas funções, aproveitando o conhecimento dos atuais funcionários. As áreas de recursos humanos deverão elaborar planos e alocar recursos financeiros para a dispensa de funcionários. As áreas de marketing e tecnologia da informação (TI) devem redirecionar os investimentos para novas soluções de relacionamento com clientes baseadas em redes sociais e Big Data. A área de Compras deverá avaliar os impactos dos cancelamentos de contratos de serviços e infraestrutura. A área de Patrimônio deve elaborar uma estratégia para reaproveitar ou liberar espaço físico dos prédios e seu impacto no IPTU. A área de finanças deverá avaliar a amortização dos ativos do Contact Center. As empresas de terceirização de serviços de Contact Center deverão se transformar em empresas de soluções avançadas de relacionamento com clientes. Os sindicatos devem assumir a responsabilidade de treinar seus afiliados em novas habilidades para competir no setor. O Ministério do Trabalho deve acompanhar e criar programas de capacitação para recolocar os trabalhadores em outros setores do mercado.

Retardar a adoção de novas tecnologias não é uma opção, ela é mandatória devido à mudança de comportamento dos consumidores. Quem não se mexer agora perderá a competitividade no mercado.