Como levar serviços de saúde para mais de 9 bilhões de habitantes em 2050? Como levar serviços de saúde para regiões remotas de baixa densidade populacional? Como diagnosticar doenças em estágios iniciais para salvar vidas e ao mesmo tempo reduzir os custos dos serviços de saúde?

Esses desafios só poderão ser vencidos com tecnologia. Pensar em um sistema de saúde tradicional com médicos em todas as localidades exigiria um grande esforço na formação de médicos, enfermeiros e técnicos em saúde, além de infraestrutura física e equipamentos para exames e diagnósticos.

A população estimada pelo IBGE para o Brasil em 2050 é de 226 milhões de habitantes. Em 2013, segundo a OMS, havia 17,6 médicos no Brasil para cada 10 mil pessoas, metade de médicos na Europa (33,3 a cada 10 mil habitantes). Entretanto, nos Estados da região Norte, são apenas 10 médicos por 10 mil pessoas, contra 26 médicos por 10 mil habitantes na região Sudeste. A situação é mais crítica na África que existem 2,5 médicos para cada 10 mil habitantes.

Outro fato a considerar é o aumento da população idosa e o aumento da expectativa de vida de 73,9 anos em 2013 para 80,7 anos em 2050 e 81,2 anos em 2060. Isso implica na necessidade de ampliação dos serviços de saúde para atender aos idosos e as doenças associadas a idade. Deve-se considerar que parte dessa população viverá sozinha e uma parcela com dificuldades de locomoção. A maior parte dessa população deverá optar pelo serviço público de saúde, devido aos altos custos dos planos de saúde particulares. Talvez, pelo alto custo de vida nas grandes metrópoles, parte dessa população opte por migrar para cidades menores com custo de vida mais baixo.

O IBGE estima que a partir de 2043 a população brasileira começará a reduzir, de 228 milhões em 2040 para 218 milhões em 2060, projetando uma redução da taxa de natalidade. Menos trabalhadores exigirá maior produtividade e prolongamento das horas trabalhadas. Isso exigirá mais cuidado com a saúde para evitar doenças associadas ao stress e sedentarismo. Essa preocupação já existe em regiões mais desenvolvidas, incluindo São Paulo. Tanto que houve uma explosão de softwares para smartphones para monitoram a qualidade de vida de seus usuários, incluindo sensores para alguns sinais vitais de vida.

A Internet of Things (IoT) terá um papel importante nesse contexto. A partir de dispositivos remotos com sensores para monitorar sinais vitais e movimentos bruscos (uma queda, por exemplo) as centrais de monitoração de saúde poderão acompanhar milhões de pessoas de todas as idades, alertando sobre comportamentos que levem a riscos de saúde e emitirem sinais de socorro em caso de insuficiência de algum sinal vital.

A tecnologia IoT dará mais independência para os idosos que poderão viver sozinhos em suas casas e ter acompanhamento remoto, incluindo algumas análises clinicas remotas. Quando algum sinal de atenção for identificado a pessoa será convidada a ir até um posto de saúde. Isso evitará filas para atendimento e poderá definir a alocação de médicos e equipamentos de acordo com a demanda.

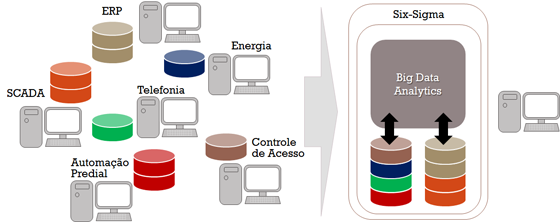

Com os dados coletados dos dispositivos remotos, dos exames clínicos e dos diagnósticos dos médicos será possível, através de Big Data e ferramentas avançadas de análise de dados (Analytics), identificar endemias, e tomar ações públicas para evitar epidemias e pandemias. Outro benefício é prever a necessidade de medicamentos e insumos para exames de laboratórios, além de indicar sintomas para diagnósticos mais rápidos e precisos.

Big Data e ferramentas analíticas permitirão diagnósticos mais rápidos e precisos e serão fundamentais para um novo modelo de atendimento de saúde. Isso permitirá que diagnósticos preliminares poderão ser realizados pelos agentes comunitários de saúde quando visitam as casas das pessoas, seguindo o modelo atual do SUS (Sistema Único de Saúde), principalmente na identificação de endemias e acompanhamento de saúde de idosos.

Já estão disponíveis equipamentos de diagnóstico com 33 testes por US$800 por unidade na Índia. Os testes incluem HIV, sífilis, oximetria, pulso e troponina (relativo a ataques cardíacos). Esses equipamentos permitiram aumentar o número de consultas pré-natais de 0,8 para 4,1 por mãe. Os sensores de pressão arterial e urina permitiram o diagnóstico de uma condição chamada de pré-eclâmpsia, que é responsável por 15% da mortalidade das mães. Com os procedimentos anteriores detectavam a pré-eclâmpsia muito tarde, 8 de cada 10 mães faleciam. Depois de implantado os equipamentos de diagnóstico, de 1.000 mães rastreadas, detectou-se 120 mães com pré-eclâmpsia em estágios iniciais e todas foram salvas.

O fator de sucesso dessa iniciativa foi a construção de uma variedade de aplicativos baseados em inteligência artificial para os agentes comunitários de saúde para identificar as doenças em seus estágios iniciais, salvando vidas e reduzindo os custos dos tratamentos em hospitais e medicamentos.

Não restam dúvidas que novos equipamentos, tecnologias de informação e comunicação móvel são fundamentais para melhorar a qualidade de vida das pessoas e reduzir os custos dos serviços de saúde.